Марковский процесс принятия решений

Марковский процесс принятия решений (англ. Markov decision process (MDP)) — спецификация задачи последовательного принятия решений для полностью наблюдаемой среды с марковской моделью перехода и дополнительными вознаграждениями. Назван в честь Андрея Маркова, служит математической основой для того, чтобы смоделировать принятие решения в ситуациях, где результаты частично случайны и частично под контролем лица, принимающего решения. Сегодня эта спецификация используется во множестве областей, включая робототехнику, автоматизированное управление, экономику и производство.

Определение

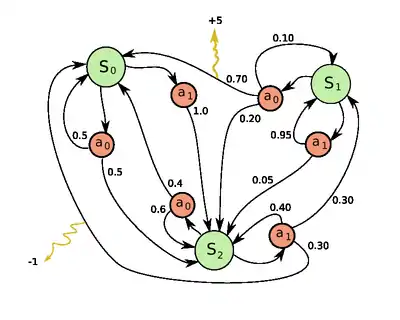

Пример MDP с 3 состояниями и 2 действиями

Чтобы определить марковский процесс принятия решений, нужно задать 4-кортеж , где

- конечное множество состояний,

- конечное множество действий (часто представляется в виде множеств , доступных из состояния ),

- вероятность, что действие в состоянии во время приведет в состояние ко времени ,

- вознаграждение, получаемое после перехода в состояние из состояния с вероятностью перехода .

См. также

This article is issued from Wikipedia. The text is licensed under Creative Commons - Attribution - Sharealike. Additional terms may apply for the media files.